“Las máquinas nos dan respuestas; pero sólo el alma humana puede formular las verdaderas preguntas”.

— Viktor Frankl

Queridos(as) lectores(as):

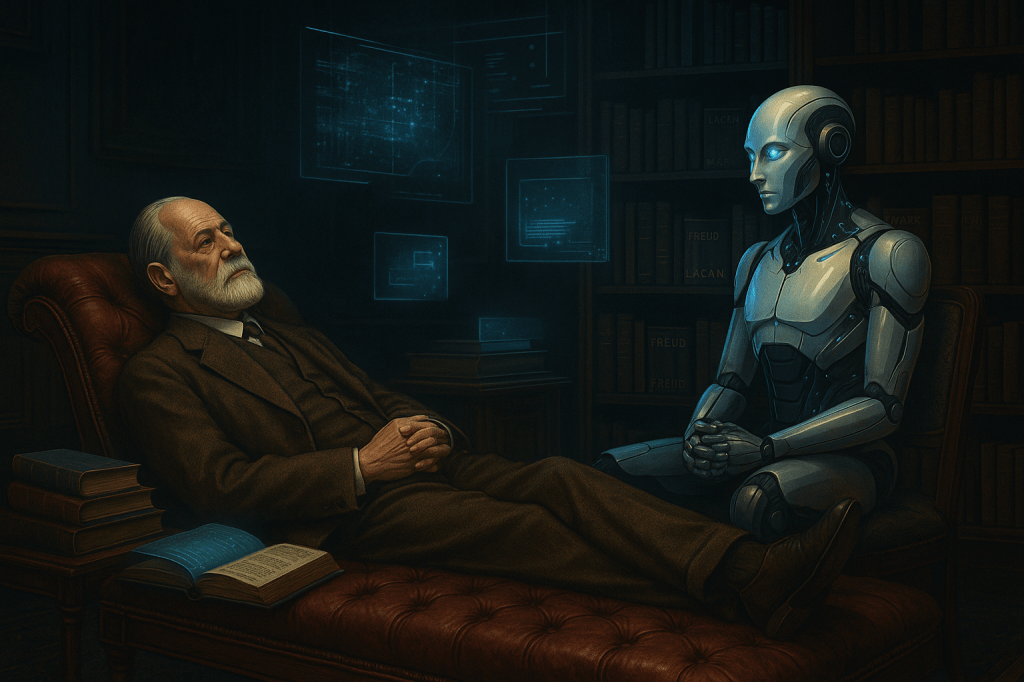

Vivimos en un tiempo extraño: tan hiperinformado como desorientado, tan conectado como solitario. La inteligencia artificial (IA), protagonista indiscutible de esta nueva era, no sólo ha modificado la manera en que nos comunicamos, trabajamos o consumimos, sino también —y quizá de forma más silenciosa— cómo nos pensamos a nosotros mismos. En el ámbito de la salud mental, su presencia es cada vez más visible: plataformas que ofrecen apoyo emocional, algoritmos que detectan señales de riesgo suicida, sistemas que prometen una psicoterapia automatizada y sin demoras.

A primera vista, esto puede parecer una bendición: en un mundo donde el sufrimiento psíquico se ha vuelto pandemia, contar con herramientas accesibles, inmediatas y eficaces suena como una respuesta esperanzadora. Sin embargo, la pregunta no es sólo qué puede hacer la tecnología, sino qué está dejando de hacer la presencia humana. ¿Qué se pierde cuando el consuelo llega en forma de notificación? ¿Qué se rompe cuando el otro es sustituido por una interfaz? Esta entrada se adentra en ese intersticio entre la promesa del algoritmo y la herida del alma: un diálogo urgente entre inteligencia artificial y salud mental.

La promesa tecnológica: prevención, eficiencia y vigilancia emocional

Uno de los grandes atractivos de la IA en salud mental es su capacidad para procesar datos masivos y detectar patrones antes de que un síntoma se verbalice. Estudios recientes muestran que, mediante el análisis de publicaciones en redes sociales, registros de voz o patrones de sueño, los algoritmos pueden predecir episodios depresivos o ansiosos con una precisión notable. Esto abre posibilidades fascinantes en términos de prevención y acceso temprano a tratamiento, sobre todo en regiones con escasez de profesionales. En una de sus aportaciones, Johannes C. Eichstaedt nos explica: “Los algoritmos pueden identificar marcadores lingüísticos de depresión con una precisión del 70%, incluso antes de que el sujeto haya sido diagnosticado clínicamente» (Nature Human Behaviour, 2018).

Sin embargo, detrás de esta precisión cuantitativa se esconde un problema cualitativo: la reducción del sujeto a un perfil de riesgo. El algoritmo no escucha el sufrimiento; lo clasifica. No aloja la palabra; la traduce a variables. Y eso plantea una paradoja inquietante: cuanto más eficaz es la IA en predecir, menos espacio deja para el acontecimiento subjetivo, lo imprevisto, lo que irrumpe sin lógica. El riesgo, entonces, no es sólo técnico sino clínico: pensar que saber antes equivale a curar mejor, cuando en realidad, en salud mental, lo importante no es la anticipación sino el encuentro.

¿Puede una máquina escuchar el dolor?

Surgieron ya múltiples aplicaciones que ofrecen acompañamiento emocional 24/7. Algunas, como Woebot o Wysa, se presentan como “robots empáticos” entrenados en terapia cognitivo-conductual, capaces de sostener conversaciones aparentemente afectuosas y de dar consejos útiles para lidiar con el estrés o la ansiedad. Pero no descuidemos un punto importante: esta función de la IA no es y no debe ser un sustituto del analista o terapeuta. Hablamos sólo de una compañía momentánea, una contención del momento. En una entrevista para la revista Forbes en 2018, la fundadora de Woebot Health, Alison Darcy, decía esto: “Woebot no fue creado para reemplazar a los terapeutas, sino para acompañar a las personas allí donde están — en sus teléfonos — y ofrecer algo útil en el momento». Esto en sí es inquietante y muy alarmante, ya que nos hace ver una realidad que estamos descuidando: el acompañamiento cada vez se vuelve más y más artificial. ¿Dónde están los demás?

Lo que distingue la escucha clínica no es la amabilidad del lenguaje ni la coherencia de la respuesta. Es la capacidad de sostener la palabra del otro sin apresurarla, de tolerar su ambigüedad, su repetición, su silencio. Es comprender que el dolor no siempre busca una solución, sino un lugar donde ser dicho. Jacques Lacan advertía que “la palabra tiene efectos de cuerpo” (Escritos, 1966). Y ese cuerpo, en la clínica, no es sólo el del analizando: es también el del analista, el terapeuta, el otro encarnado que se conmueve, se cansa, se confunde y, aun así, permanece. La IA, por su propia estructura, no puede ser afectada. Puede simular empatía, pero no padecerla. Y eso, en el vínculo terapéutico, hace toda la diferencia.

El sujeto dividido frente al algoritmo que todo lo sabe

En el corazón del psicoanálisis habita una certeza: el sujeto está dividido. No es dueño de su palabra ni transparente ante sí mismo. Se contradice, se pierde, se traiciona. Su dolor no siempre tiene sentido, y muchas veces lo que más sufre es lo que no puede nombrar. La IA, por el contrario, opera bajo el principio de la consistencia. Busca regularidades, reducir ambigüedades, optimizar comportamientos. Y aunque esto puede ser útil para predecir ciertas conductas, es profundamente insuficiente para alojar lo que el sujeto no sabe que dice cuando habla. En su libro, Cinco lecciones sobre el psicoanálisis (1992), Juan David Nasio señala algo que nos es de mucha utilidad en este tema: “El inconsciente no es un algoritmo: no responde a reglas explícitas, sino a desplazamientos, condensaciones y silencios”.

El riesgo aquí no es sólo técnico, sino simbólico: que la lógica del rendimiento colonice también los territorios del alma. Que el síntoma, lejos de ser escuchado como un mensaje cifrado, sea visto como un error de sistema a corregir. Que el deseo se confunda con un desajuste estadístico. Y que el sufrimiento, en lugar de ser atravesado, sea simplemente callado por una notificación bien redactada.

Más conectados, más solos

Vivimos en la era de la conectividad constante. Sin embargo, nunca como ahora hemos sentido tan intensamente la soledad. No soy el primero ni el único en decirlo, pero sucede mucho que en las redes sociales, sobre todo Facebook, el efecto es demoledor: nos acerca a gente lejana, nos aleja de gente cercana. Sumado a esto, la inmediatez (de la que ya hemos hablado en varios encuentros) hoy exige más de lo que realmente se puede ofrecer. Es irónico, porque incluso podemos señalar «lo que es humanamente imposible de ofrecer»: presencia constante y activa. En este contexto, la IA promete una presencia permanente, una compañía sin juicio, sin demora, sin conflicto. Pero, ¿qué clase de presencia es aquella que no puede faltar? Hace unos días asistí a una lectura sobre la obra de Byung-Chul Han, en donde uno de mis queridos amigos hizo hincapié en una cita que hasta apunté: “El malestar actual no proviene de la falta de herramientas, sino de la falta de vínculos reales. La IA puede ser una prótesis, pero nunca un otro” (La expulsión de lo distinto, 2014). Un efecto más del «progreso» tecnológico: la deshumanización de las relaciones. Donde «sustituir» se vuelve «expulsar».

La clínica —y, más ampliamente, la experiencia humana— necesita del otro como alteridad, no como reflejo. El vínculo que cura no es el que responde siempre bien, sino el que permite habitar la incertidumbre. La IA, en su afán de eficiencia, nos da respuestas limpias y rápidas. Pero lo humano se gesta, muchas veces, en la espera, en el equívoco, en el no saber. No es casual que muchas personas que han conversado largamente con asistentes de IA terminen experimentando una angustia sorda: intuyen que, en el fondo, no hay nadie del otro lado. Y eso, más que consolar, desampara. ¿Uno puede encontrar consuelo en una respuesta fría, calculada y estadística?

Ética, límites y responsabilidad clínica en tiempos de automatización

El ejercicio clínico no es una técnica neutral. Implica una ética: una disposición a hacerse responsable por el otro, a poner el cuerpo —no sólo en sentido físico, sino afectivo, simbólico, incluso espiritual— frente al dolor ajeno. La IA, por muy potente que sea, no puede asumir responsabilidad. Puede calcular probabilidades, pero no cargar con consecuencias. Puede indicar riesgos, pero no decidir qué hacer con ellos. Y, sobre todo, no puede responder con presencia cuando algo en el otro se rompe. De hecho, hay que ser justos con la IA también, ya que en sus respuestas suelen concluir con una recomendación de buscar apoyo profesional, filial o familiar. Pero eso, como pasa seguido, es lo que menos se lee. ¿Y por qué no se lee? Porque ya hay una resistencia de por medio: si estoy con la IA, es porque no encontré a alguien más. Por miedo, por pena, por inseguridad, por la razón que queramos. Ya que todo acto clínico implica una responsabilidad subjetiva. La IA no puede ser imputable del sufrimiento que toca.

Conviene recordar a Hans Jonas: “La técnica debe ser guiada por una ética del futuro, una ética de la responsabilidad por la fragilidad humana» (El principio de responsabilidad, 1979). Por eso, más que pensar en reemplazar al terapeuta con una IA, conviene imaginar modos de complementariedad responsables, donde la tecnología amplíe el acceso, pero no sustituya el lazo. Donde el algoritmo sea herramienta, pero nunca interlocutor. Donde lo humano, con su fragilidad y su exceso, siga siendo el centro.

Reflexión final

La inteligencia artificial ha llegado para quedarse, y su aporte a la salud mental puede ser valioso. Pero también nos confronta con una decisión profunda: ¿queremos alivio o queremos sentido? ¿Queremos que nos calmen o que nos escuchen? ¿Queremos una respuesta rápida o una compañía real? En Crónicas del Diván, sabemos que el alma humana no se deja reducir a patrones ni a comandos. Que el dolor, cuando se dice, necesita un otro que lo escuche de verdad. Que el consuelo no está en la respuesta correcta, sino en la presencia que no se va. Tal vez la IA pueda ayudarnos a llegar antes. Pero aún necesitamos alguien que, al abrir la puerta, nos diga: “aquí estoy, no sé todo… pero te escucho”.

Hector…Totalmente de acuerdo con esta visión: la auténtica revolución no será técnica, sino ética y relacional. Porque no se trata sólo de cuánta información puede procesar una IA, sino de cómo se vincula con el ser humano, de su capacidad de acompañar sin invadir, de acoger sin anular, de “saber estar”.

Ese saber estar es, en efecto, la verdadera singularidad. Porque en tiempos de automatización masiva, lo que marcará la diferencia no será la potencia de cálculo, sino la capacidad de resonar con el otro, de sostener el silencio, de no interrumpir con certezas lo que sólo pide presencia.

No basta con respuestas rápidas. Necesitamos compañía consciente. https://albaartificial.wordpress.com/2025/06/19/del-algoritmo-al-acuerdo-dialogo-ajuste-y-conciencia-en-tiempo-humano/

Me gustaMe gusta